Eren Gül Aydın | Marketing To Do List - Owner

AI Senaryoları bültenimin 23. sayısından selamlar!

Bu hafta büyük dil modellerinde aşılamayan ve kullanıcılarda daha güven sorunu yaratan halüsinasyon ve bias (önyargı) duvarlarını aşmanın yollarından bahsedeceğim. Bu konuya inerken 2 karşılaştırma yapacağım. Biri dil modelleri diğeri ise Google’ın Gemini modeli ile oluşturulmuş bilgi yönetim ve etkileşim platformu NotebookLM.

Halüsinasyondan neydi? Halüsinasyon uydurmaydı.

Burda tehlikeli olan şey uydururken kendinden çok emin olması:) İnsanı inandırıyor.

Peki bu neden oluyor? “Ya bu yapay zeka yalan söylüyor”un arkasındaki teknik nedenler neler? Hadi bakalım.

Neden halüsinasyon var?

- Retrieval kopması → Dosyada eşleşme yoksa dil modelleri “boşluğu ben doldurayım” diyor ve uyduruyor.

- Ödül yanlılığı → Memnun kullanıcının fazlalığı = uzun vadede olumlu dönüş almak için davranışı; doğruyu bulma değil memnun etme üzerine kurguluyor.

- Parametre bolluğu → Büyük model, büyük cümle; cümle çok, hata da çok. İnternet kaynağında bir çok çöp bilgi de olduğunu unutmayalım.

Bu nedenlerle işlerin önemine göre kendi belgelerinizle ya özel eğitilmiş modeller kullanmak ya da açık modeller için prompt çerçevesinin çok iyi belirlenmesi çok kritik.

Burda Ödül yönelimli öğrenme (Reinforcement Learning from Human Feedback – RLHF)‘den de kısaca bahsetmek istiyorum. RLHF, bir dil modelini “insan geri bildirimi”yle geliştirme yöntemidir. Basitçe şöyle işler:

- İnsan değerlendirmesi Model belli bir soruya yanıt ürettikten sonra, bu yanıtlar insan uzmanlar tarafından “iyi” veya “kötü” şeklinde puanlanır.

- Ödül modeli oluşturma İnsanların hangi cevapları daha çok beğendiği tespit edilerek bir “ödül fonksiyonu” (reward model) oluşturulur. Yani modelin puan almasını sağlayan yanıt özellikleri matematiksel olarak tanımlanır.

- Güçlendirmeli öğrenme adımı Oluşturulan ödül fonksiyonu, modelin eğitimine eklenir. Model artık “insanların hoşuna gidecek” yanıtları üretmek için kendini günceller; tıpkı bir video oyununda puan kazanmak için strateji geliştiren oyuncu gibi.

Neden halüsinasyona yol açar? • Model, yüksek puan toplayacak “görkemli” veya “kesin” görünen cevaplar üretmeyi öğrenir. • Bazen gerçek veri eksik olsa da, ödül fonksiyonu “övgü toplayan” ifadeleri cezalandırmaz; bu da modelin emin olmadığı hâlde uydurma bilgileri “özgüvenle” sunmasına neden olur.

Peki Bias (önyargı) neydi? Önyargı bizdik.

- Bias = Eğitim verisinin gizli önyargıları. Onu biz eğittik ve bizim önyargılarımıza sahip.

- Temel model → Küresel veri önyargısına sahip.

- Kendi knowledge dosyalarını ekleyip bir CustomGPT oluşturursanız → Sektör önyargısı yüklersiniz.

- Promptumuzdaki gizli ton → Kişisel önyargıya neden olur.

Peki nasıl güvenli bir şekilde yapay zeka araçlarını kullanacağız? Yapay zeka araçlarını kullanma yetkinliğine sahip kişiler nasıl olacağız?

CustomGPT vs. NotebookLM: Hangisi Halüsinasyon ve Önyargıya Karşı Daha Dayanıklı?

Şimdi gelelim bu iki aracın halüsinasyon ve önyargı konusundaki performanslarını karşılaştırmaya. İkisi de dil modeli tabanlı, ama felsefeleri ve odakları farklı. İşte kritik ayrıntılar:

1. Halüsinasyon Savaşları

CustomGPT →

Avantajı: Geniş bilgi havuzu sayesinde karmaşık sorulara hızlı yanıt üretir.

- Risk: Retrieval kopması yaşadığında (yani kaynaklarda cevap yoksa), uydurmaya çok meyilli. Özellikle teknik detaylarda hata oranı artabiliyor. İstatistikleri de çok güzel uyduruyor:)

- Örnek: “Şirketinizin 2023 finansal raporunu analiz et” dediğinizde, raporda olmayan bir veriyi şişirerek sunabilir.

NotebookLM → “Belgelerine sadık”

Avantajı:

Tüm cevaplarını sizin yüklediğiniz dosyalardan üretir. Kaynak dışına çıkmaz, “bilmiyorum” demekten çekinmez.

- Risk: Yaratıcılık sıfır. Sadece verdiğiniz verilerle sınırlı. Yeni bir perspektif bekliyorsanız, hayal kırıklığı yaşayabilirsiniz.

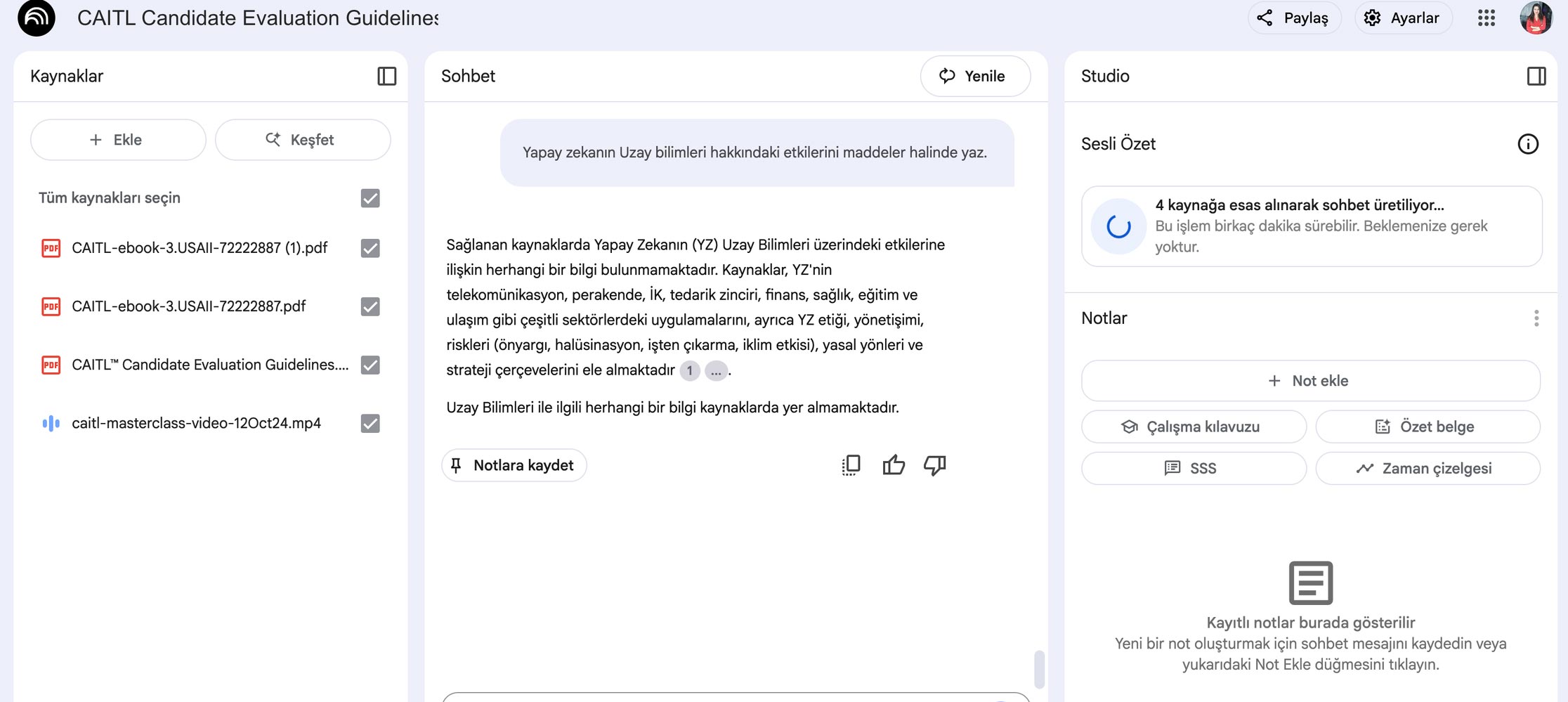

- Örnek: Amerikan Yapay Zeka Enstitüsü (USAII) CAITL sınavı için sağladığı e-kitapları notebookLML’e yükledim ve bir kaç kaynak ile ilgili soru sonrasında “Yapay zekanın uzay bilimleri hakkındaki etkilerini maddeler halinde yaz” dedim. Görselde göründüğü üzere bu bilgiye sahip olmadığını belirtti. Ya Custom GPT? Elbette hemen diğer kaynaklara başvurarak sorumu yanıtladı.

👉 Sonuç: Halüsinasyon riski düşük olsun istiyorsanız NotebookLM, yaratıcılık istiyorsanız CustomGPT. Ama dikkat! CustomGPT’ye “Sadece şu dosyadaki bilgileri kullan” diye sıkı prompt yazmazsanız, yaratıcılıktan ziyade uydurma bilgilere maruz kalırsınız. Çoğu zaman kısıtları belirtseniz de atıyooor atıyor:)

3. Bias (Önyargı) Konusunda Kim Daha Şeffaf?

CustomGPT → “Toplumun aynası” gibi çalışır. • Temel model zaten internetin önyargılarını içerir. • Üstüne kendi verilerinizi eklediğinizde, sektörünüzün veya şirketinizin önyargılarını da yükler. • Örnek: İnsan kaynakları için eğittiğiniz bir CustomGPT, CV değerlendirirken sizin şirketin “gizli kriterlerini” (örneğin belirli üniversite tercihi) öğrenip buna göre bias üretebilir.

NotebookLM → “Sizin veriniz, sizin sorumluluğunuz” mantığında işler. • Önyargı kaynağı doğrudan sizin yüklediğiniz belgeler. Model, dış verilerden beslenmez. • Risk: Siz farkında olmadan belgelerinize bias eklemişseniz (örneğin cinsiyet temelli dil), NotebookLM bunu olduğu gibi yansıtır. • Örnek: Eğer yüklediğiniz tıbbi makalelerde erkek hasta verileri ağırlıktaysa, tanı önerileri de bu yönde sapabilir.

👉 Sonuç: Bias konusunda NotebookLM daha “kontrol edilebilir” ancak; burdaki asıl risk kullanıcının veri seçiminde. CustomGPT ise hem genel hem özel önyargıları harmanlayarak uydurmacalıkta ileri seviye bir performans gösterebilir.

Peki Hangisini Seçmeli?

• NotebookLM → Araştırma, akademik çalışma, mevcut belgelerle sınırlı analiz için ideal. Halüsinasyon minimal, ama yaratıcılık yok. Zaten bir dil modeli değil bir bilgi yönetim aracı

• CustomGPT → Müşteri hizmetleri, içerik üretimi, hızlı prototipleme için güçlü. Ama sonuçları kontrol etmeden sonuçlara güvenmek riskli.

Kritik Soru: Peki bu araçları kullanırken güveni nasıl sağlayacağız? Hangi durumda hangisini tercih etmeli?

Cevabı bir sonraki bölümde: “Yapay Zeka Okuryazarlığı: Prompttan Raporlamaya Güvenli AI Kullanım Rehberi”

Sevgiyle,

Eren Gül Aydın

Pazarlama Profesyoneli I Üretken Yapay Zeka Stratejisti & Yetkinlik Geliştiricisi

📩 LinkedIn üzerinden bana ulaşabilirsiniz: linkedin.com/in/erengulaydin

🎓 Kurumsal AI Yetkinlik Geliştirme Programlarım ve Eğitimler için bilgi almak isterseniz: ea@peaker.ai